Начну с того, что я оказываю данную услугу ориентировочно с 2015 года.

Большинство проектов, которые приходят ко мне на аудит из Казахстана, но есть и клиенты из ближнего зарубежья — Россия, Узбекистан и другие.

С некоторыми клиентами мы проводим спустя время повторный аудит, как правило, это делается в связи с серьезной доработкой движка сайта сайта.

Один из таких примеров — Edok.kz — агрегатор по доставке еды в Казахстане.

В том числе благодаря правкам после моих аудитов, проект хорошо растет.

- На что обращаю внимание во время аудита

- Технические файлы сайта

- Разбор главной страницы сайта

- Обращаю внимание на 404 страницу

- Оптимизация категорий сайта

- Структура и оптимизация внутренней страницы товара / статьи или другого типа данных

- Исследую поисковую выдачу в Яндекс и Google

- Нестандартные типы страниц

- Использование Netpeak Spider при аудите

- Что получает клиент после SEO аудита

На что обращаю внимание во время аудита

Для начала оговорюсь, что в большинстве своем мои аудиты состоят и ручного анализа сайта со всех сторон. Помимо выписанных ошибок по SEO, я даю качественные рекомендации как решить ту или иную задачу.

С недавних пор, для более глубокого анализа сайта я начал использовать Netpeak Spider, но о нем будет чуть позже. Если кратко, то инструмент помогает увидеть то, что по факту сложно вручную найти или легко пропустить.

Технические файлы сайта

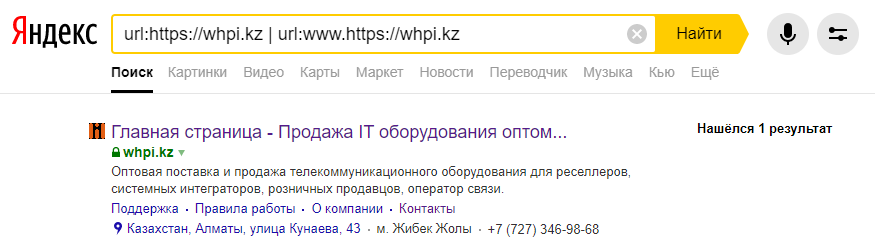

Первым на что обращаю свое внимание — технические файлы, которые влияют на правильную индексацию страниц сайта — robots.txt, sitemap.xml, правильно настроенные редиректы с www на без www и прочие технические аспекты.

На практике я встречаю сайты, которым по нескольку лет и на них даже гонится трафик из контекстной рекламы, но сайт попросту закрыт от индексации в robots.

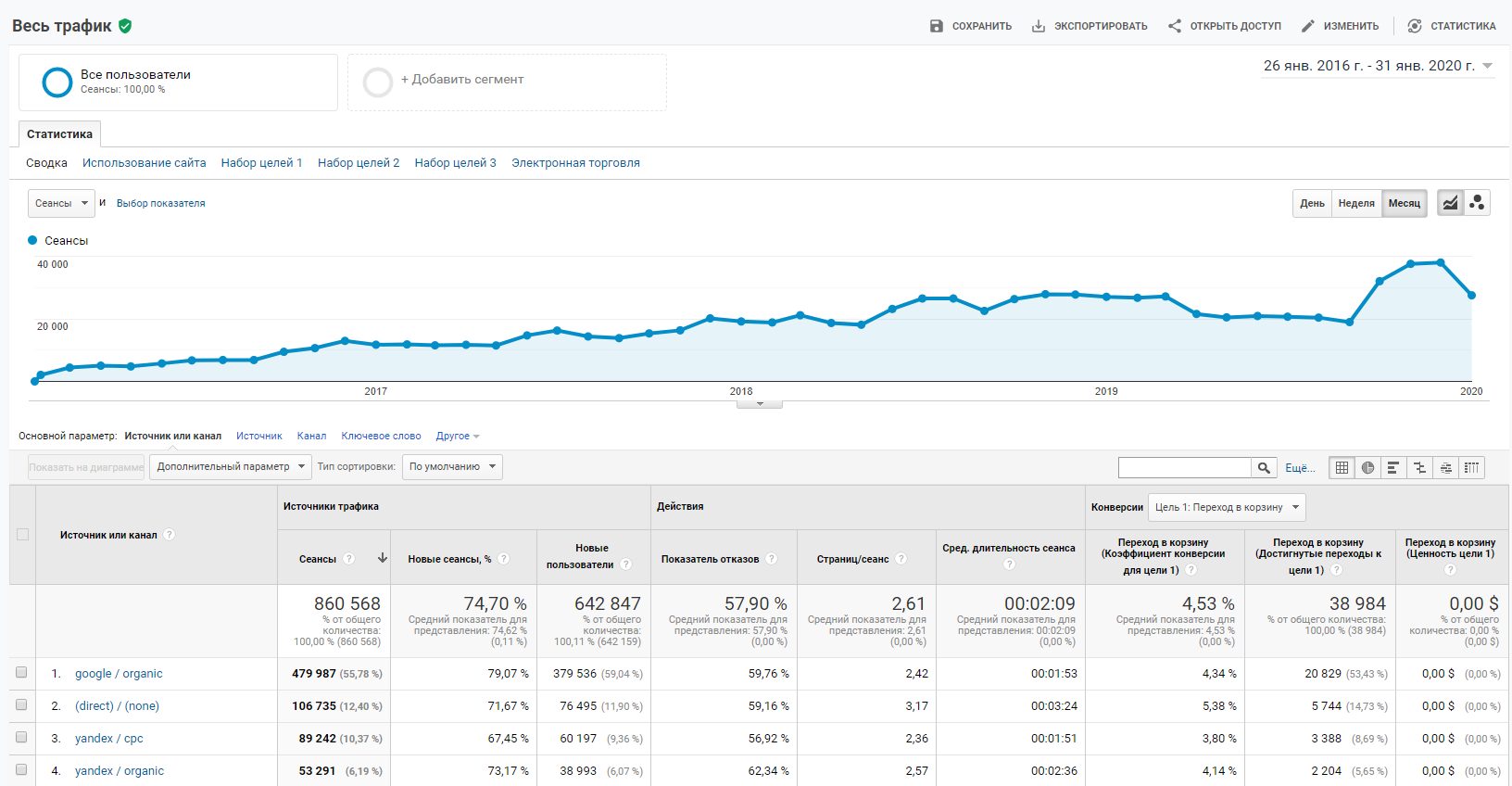

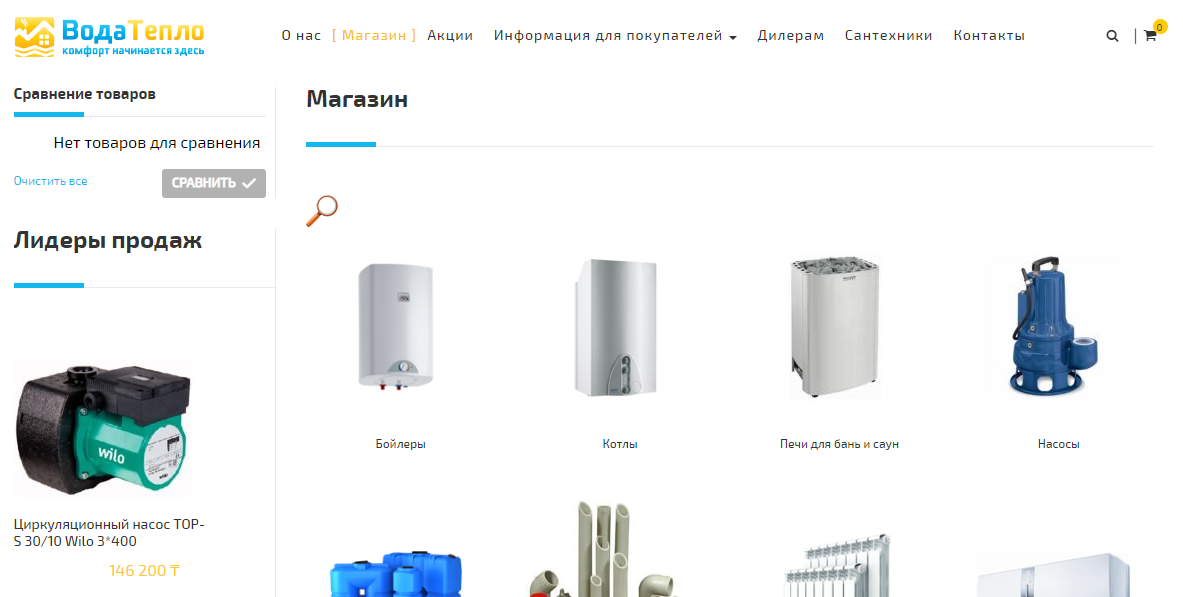

Пример такого сайта — vodateplo.kz

Я еще несколько месяцев назад указал им на то, что в файле роботс у них банально закрыт весь сайт от индексации, что они просто пропустили мимо ушей и продолжают ждать отдачи от сайта из поиска. Наивные.

Карта сайта также часто слабое место у проектов. Нередки случаи, когда xml карта сайта составлена таким образом, что все страницы сайта, а их может быть тысячи, добавлены в карту одной датой и временем. Это грубая ошибка, но тем не менее часто встречается.

Разбор главной страницы сайта

Следующее на что я обращаю внимание — главная страница сайта.

Главная страница — это своего рода лицо сайта и если там бардак по содержимому, то пользователи это не оценят, а с точки зрения SEO надо понравиться одновременно посетителям сайта и угодить алгоритмам поисковых систем.

Часто на практике встречаю красивые блоки со ссылками на внутренние разделы, но если перейти по этим ссылкам там может быть банально пусто. Все потому, что сайт сделали и запустили как есть, а доделать все нет времени.

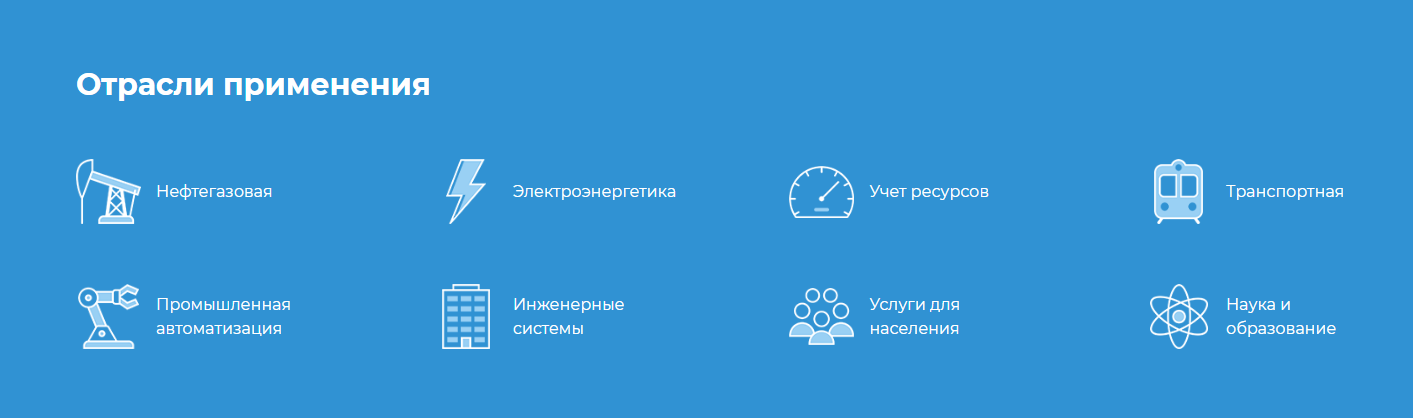

Ниже для примера блок с главной страницы одного сайта. Вполне симпатично и аккуратно сделано, но по факту внутри на 5 из 8 страниц по отраслям просто пусто — нет контента.

Ссылки на такие пустые страницы не лучшее, что могло случиться с сайтом. Как рекомендация — наконец-то найти время и все качественно заполнить.

Если говорить о мета-данных для главной страницы — часто встречаю в title главной страницы просто «Главная страница» т.е. вместо нормального заголовка, там просто констатация факта.

В данном примере еще после этой фразы есть длинный хвост, который дописывается ко всем страницам сайта и ожидаемо выходит за лимит длины title — просто обрезается по длине, как на скрине выше.

Это также является ошибкой в проработке мета-данных сайта.

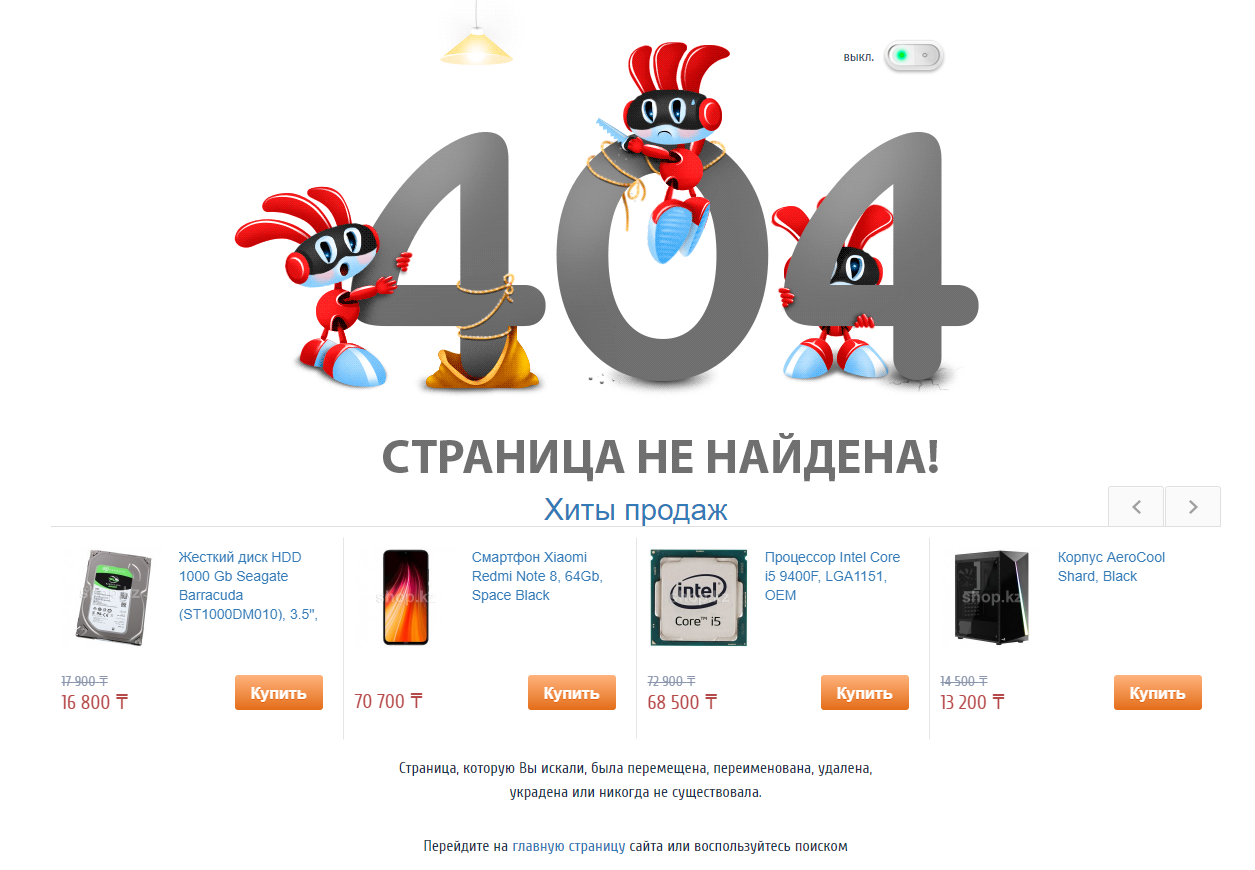

Обращаю внимание на 404 страницу

Кто-то скажет, что ерунда все это обращать внимание на то, как на сайте обрабатывается 404 код ответа сервера. А я скажу что это немаловажно, тем более у крупных проектов.

Случаев, когда пользователь попал по битой ссылке на страницу вашего сайта масса:

- кто-то в на стороннем сайте или в соц. сетях оставил некорректную ссылку на страницу вашего сайта

- в email рассылке или рекламных акциях маркетолог копируя ссылку на страницу также допустил ошибку и что-то пошло не так — пользователи переходят по ссылке, а там ошибка

- вы недавно пересобрали структуру сайта по backend и в том числе урл страниц изменились, а настроить 301 редирект как в обычно бывает на практике забыли

И многие другие причины.

Часто, страница с ошибкой 404 есть на сайте, но всегда есть варианты как сделать ее более качественно и максимально хорошо удерживать и конвертировать пользователей, а не упускать их.

Один из хороших примеров, что мне нравятся — 404 страница магазина «Белый ветер».

Блок с популярными товарами на странице с ошибкой круто ее дополняют. С большой вероятность пользователь даже попав на страницу 404 продолжит пользоваться сайтом.

Оптимизация категорий сайта

Рассматриваю как оптимизированы категории на сайте. Вне зависимости это категории товаров в интернет-магазине или категории статей в блоге. Почти всегда есть что улучшить.

Анализируя категории я смотрю на семантику по данным направлениям, анализирую сайты конкурентов и даю качественные рекомендации по улучшению посадочных страниц.

Одна из распространенных ошибок, связанных с категориях сайта — дублирующиеся мета-данные у подкатегорий. Они часто повторяют мета-данные основной категории — особенно это присуще самописным сайтам, а именно с такими часто и приходится иметь дело по аудиту.

Еще одна из частых проблем в категориях — неправильно настроенные канонические ссылки, в результате чего появляется множество дублей 1 страницы в категории при постраничной навигации.

Структура и оптимизация внутренней страницы товара / статьи или другого типа данных

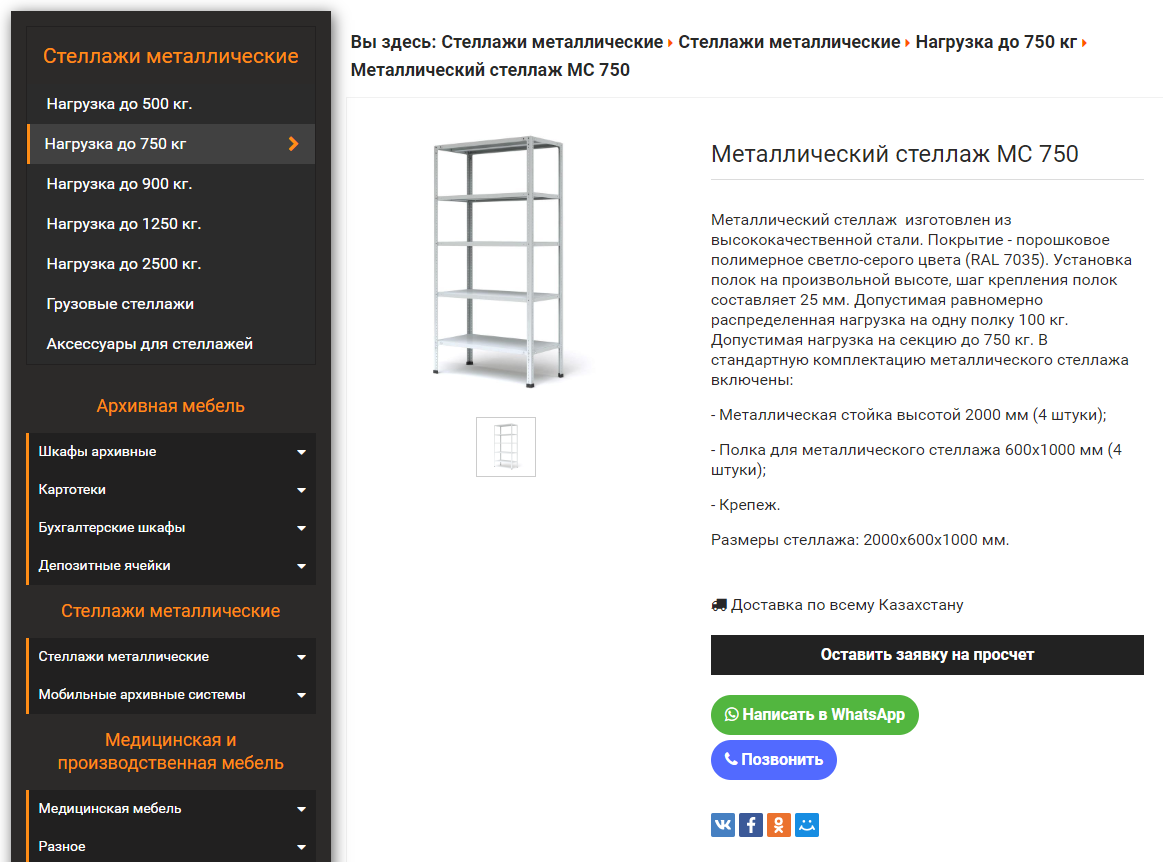

В случае со страницей товара, частая ошибка — это отсутствие должных коммерческих факторов для такого типа страниц.

Самое распространенное — отсутствие цены у товара и корзины как таковой. Нет возможности собрать товары в корзину и оформить свой заказ, не говоря уже об онлайн оплате.

Приведу пример такого проекта из моей практики. Компания занимается продажей металлической мебели и по факту у товара на скрине ниже есть четкая стоимость, но по причине жесткой конкуренции и участия в тендерах, владельцы сайта не хотят показывать цену.

Вместо корзины мы видим кнопку «Оставить заявку на просчет» — по факту под кнопкой просто форма заявки от Битрикс 24.

Для тех, кто хочет купить — это банально неудобно. Все мы знаем как на практике компании обрабатывают входящие заявки — о клиенте могут просто забыть.

Кнопки «написать в ватсап» и «позвонить» я в свое время порекомендовал им добавить и это увеличило число конверсий с сайта вдвое.

Но как ни крути — сайт по многим пунктам не проходит по коммерческим факторам для полноценного магазина и поисковики считают такой сайт в лучшем случае каталогом товаров.

Если бы в их сфере были мощные именно полноценные интернет-магазины, то с ними таким сайтом было бы непросто конкурировать.

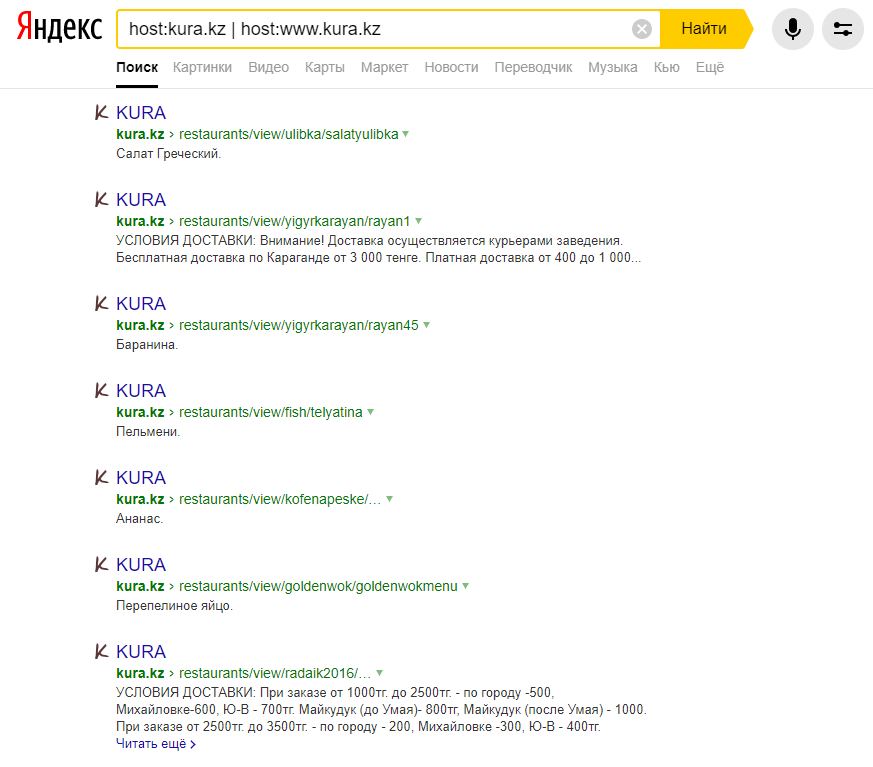

Исследую поисковую выдачу в Яндекс и Google

Бывает, что по сайту все вылизано и удобно сделано для пользователя, но достаточно взглянуть на поисковую выдачу, в жар бросает.

Один из таких примеров, который не меняется уже несколько лет — kura.kz

Сайт абсолютно не оптимизирован и банально упускает тонны потенциального трафика и клиентов, которые можно получить за счет SEO.

При этом люди достаточно неплохо пользуются данной службой доставки еды.

Бывали случаи, когда в результате анализа сайта удавалось обнаружить какие-то левые страницы, не относящиеся к сайту. Это было либо связано с вирусами, либо просто какой-то сотрудник уходя решил насолить, а владельцы сайта даже не подозревали об этом.

Нестандартные типы страниц

Встречаются на практике сайты со своеобразными типами страниц, как например, было при аудите сайта azan.kz

На сайте помимо большого количества полезной информации, разработан функционал календаря с точными датами и временем чтения Намаза.

Все бы хорошо — крутой и удобный функционал для целевой аудитории сайта, но алгоритм, который все это высчитывает и генерирует страницы наплодил в поисковой выдаче страниц на десятилетия вперед по каждому дню неделе и месяцу.

Получилось несколько десятков тысяч страниц в поисковой выдаче, актуальность которых наступит только спустя годы. Было принято ограничить генерацию подобных страниц до года.

Использование Netpeak Spider при аудите

На мои аудиты не было ни одного плохого отзыва — все клиенты были более чем довольны полученным заключением по их сайту, но я все-равно чувствовал, что можно делать это еще на порядок круче.

О Netpeak Spider, как об инструменте в своем арсенале, я задумывался давно, но до последнего откладывал. И вот буквально перед новым годом, я взял на тестовый период 14 дней попробовать данный софт.

Кстати, попробовать функционал Netpeak Spider на практике в течение 14 дней бесплатно и получить от меня персональную скидку 10% можно по ссылке — https://netpeaksoftware.com/

Скажу сразу, меня приятно удивила скорость сканирования сайта. Он как мне показалось работает на порядок быстрее других аналогов.

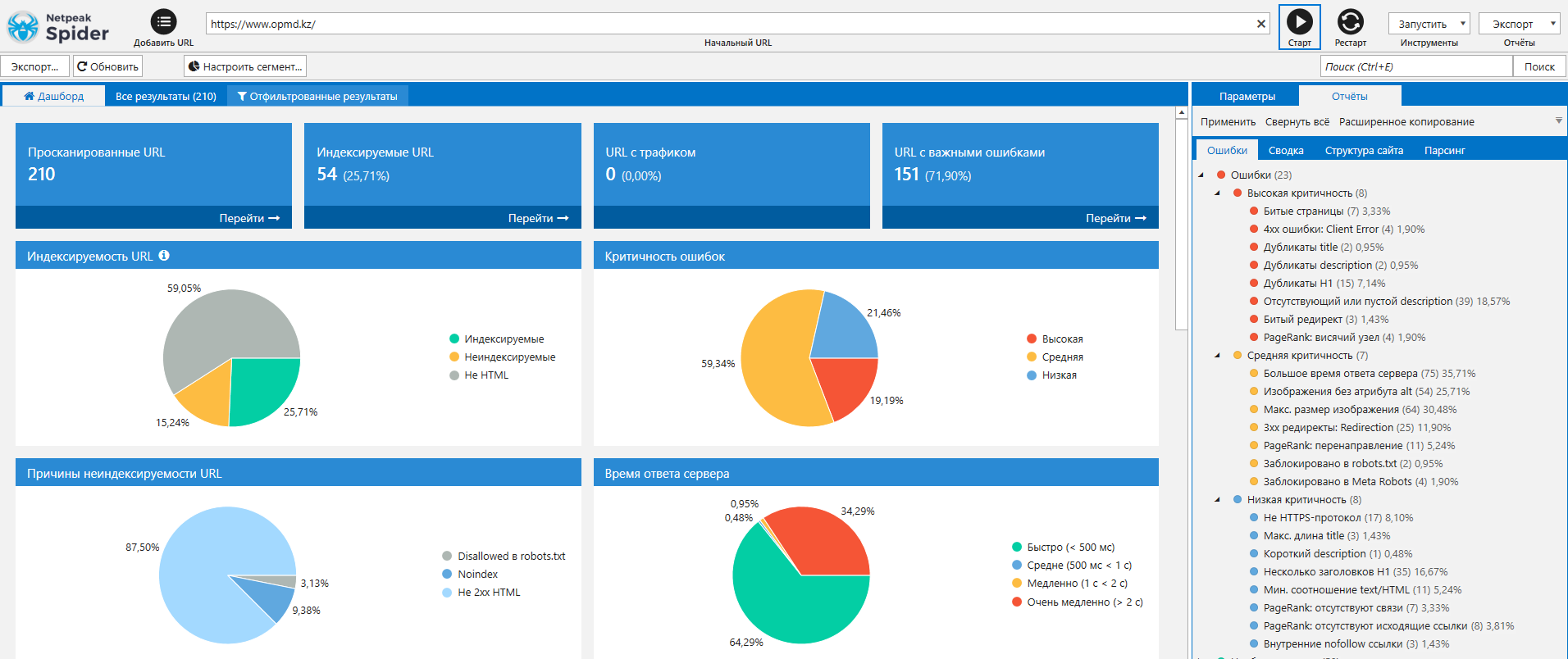

На главной странице программы есть дашборд, на котором можно можно увидеть основные показатели по факту сканирования сайта на техническую оптимизацию.

По каждому из проверяемых параметров, можно увидеть детальные результаты.

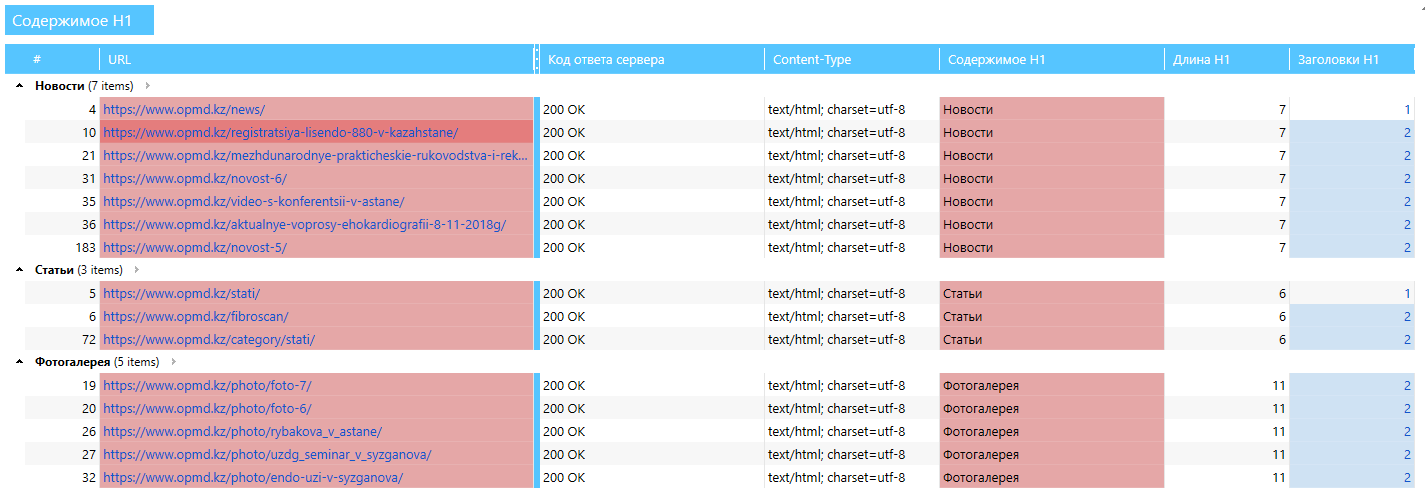

Покажу на примере дубликатов H1, которые паук выявил у данного сайта. Признаюсь, на практике при работе с сайтом я не сразу этот момент заметил.

Как мы видим, у разделов новости, статьи и фотогалерея дублируется H1. Шаблон данного сайта самописный под WordPress и косяков в нем много.

Посмотрим, как это выглядит на самом сайте. Несложно предположить, что на странице со статьей, заголовок H1 это будет непосредственно само название статьи.

Так оно и есть название данной статьи заключено в H1, но помимо этого слово «Новости», также неожиданно в теге H1.

На практике это можно запросто пропустить, банально не проверив, что из себя представляет слово «Новости» на данной странице, лишь убедившись, что название статьи корректно реализовано в H1.

По аналогии можно разбирать и другие параметры, которые сканирует программа, но что самое важное — при ручном анализе, если у сайта тысячи страниц, просто невозможно выявить, например, все страницы, у которых пустой или отсутствует description или другие моменты по оптимизации.

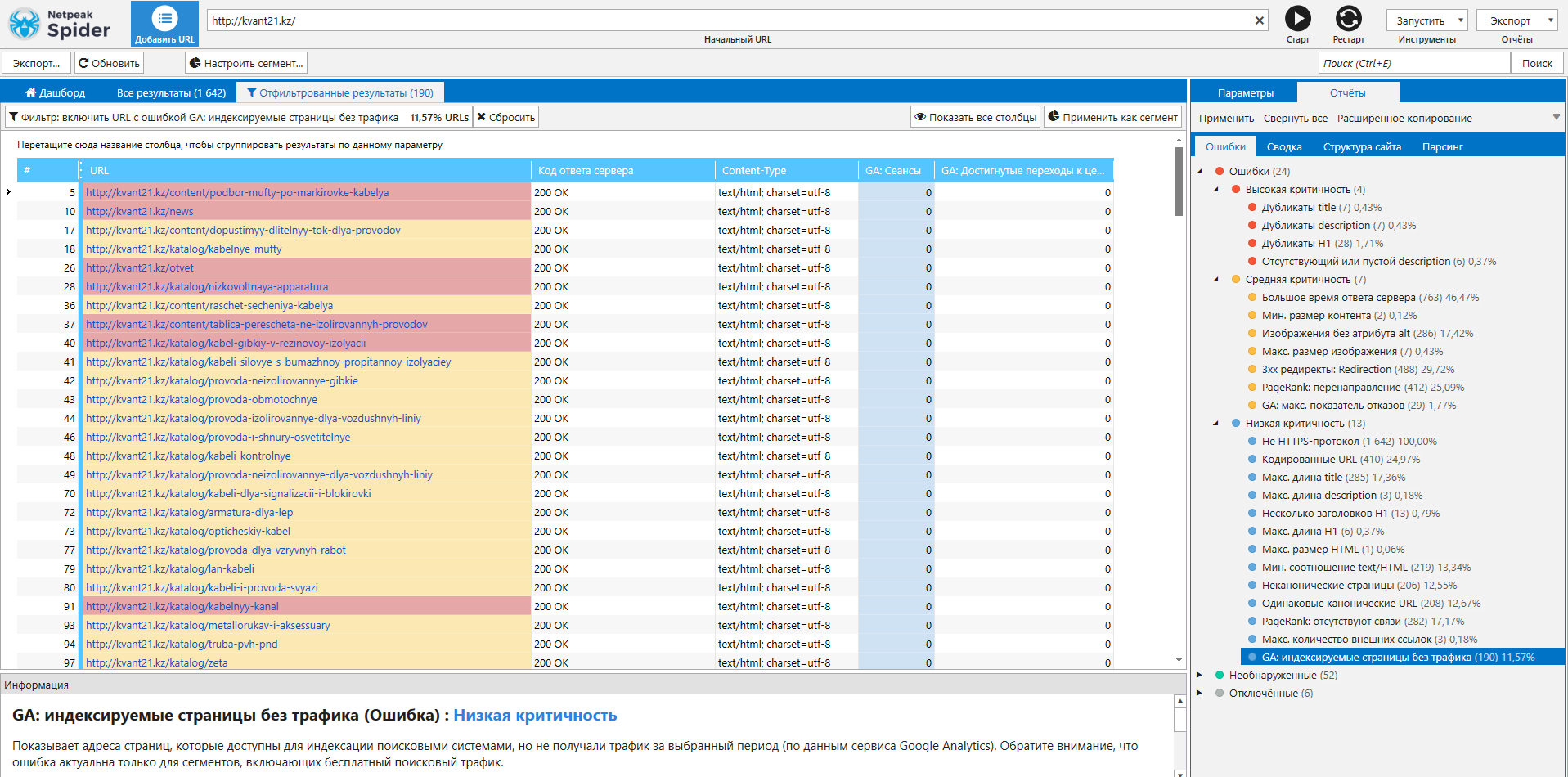

Для меня, как для SEO специалиста, одним из интересных параметров при анализе сайта, оказалось — выявление страниц, которые индексируются, но без трафика за последние 90 дней.

Есть повод задуматься почему так и доработать или удалить данные страницы вовсе.

Я как раз искал инструмент, для выявления подобных страниц на моем блоге.

Возвращаясь к ведению и развитию моего блога, который вы в данный момент читаете, у меня была идея почистить до половины старых и не актуальных статей.

Я уж было начал их искать вручную по блогу и как-то смотреть активность по каждой отдельной статье в Яндекс метрике, но тут на помощь пришел Netpeak Spider.

Что получает клиент после SEO аудита

На выходе каждый клиент получает Документ с выписанными ошибками оптимизации его сайта + рекомендации к каждому пункту, как это исправить или сделать более качественно. Своего рода ТЗ для программиста.

Документ, как правило, я собираю в Word, но скидываю также копию в формате PDF — ее удобно открыть и бегло посмотреть даже с телефона или планшета.

Если какие-то описанные мной моменты будут непонятны клиенту или программисту, выполняющему правки по проекту, я без проблем дополнительно проконсультирую.

Срок выполнения в среднем — 14 дней