В данной статье я решил разложить по полочкам такое понятие как краулинговый бюджет и разобрать факторы, которые влияют на нормальное состояние и рост краулингового бюджета.

У каждого сайта свой краулинговый бюджет и посмотреть его можно на странице https://www.google.com/webmasters/tools/crawl-stats?hl=ru&authuser=1&siteUrl

Что такое краулинговый бюджет

Простыми словами говоря, это лимит страниц, которые поисковой робот Google например обойдет для Вашего сайта за один день. Для обычных блогов с этим как правило нет проблем, а вот для больших сервисов и порталов, где ежедневно публикуется и обновляется множество нового материала и все это роботам поисковых систем нужно обойти, часто возникают проблемы с индексированием.

Владельцы порталов просто не понимают. Почему хороший и уникальный материал не попадает быстро в индекс, почему поисковые роботы его обходят стороной и не индексируют.

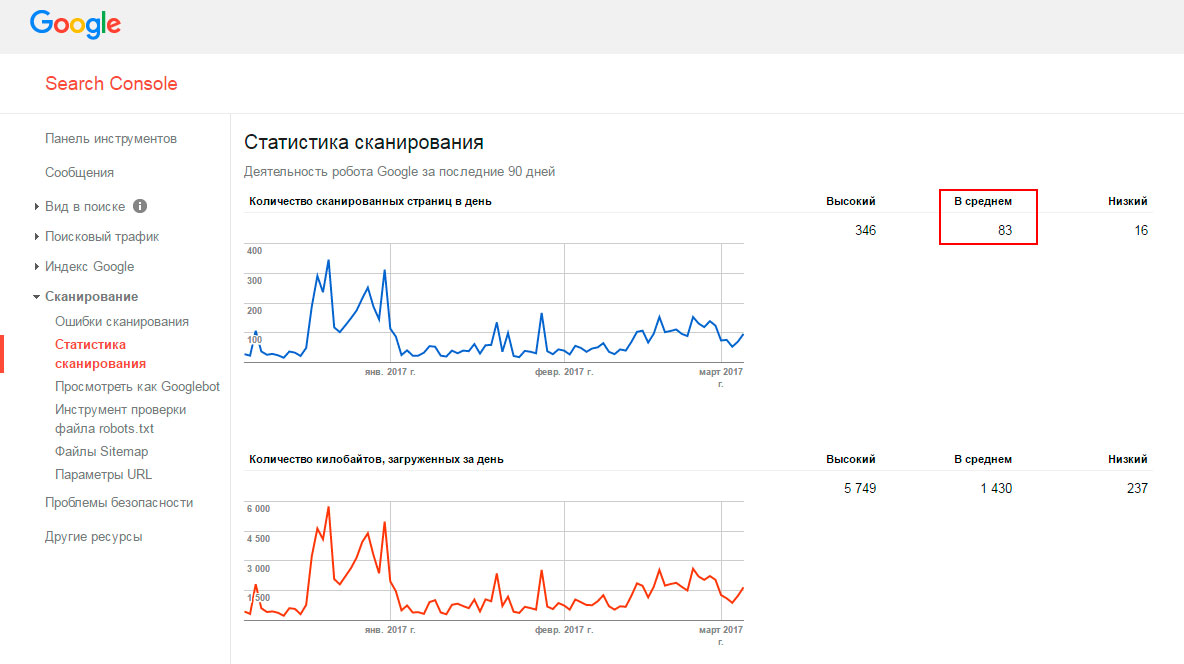

Ниже на скрине представлен краулинговый бюджет моего блога — Crawl Stats или статистика сканирование как это называется в Google. Он значительно просел в последнее время и на то есть свои причины. Буду работать над тем, чтобы увеличить этот показатель.

На скрине видно, что ежедневный краулинговый бюджет моего сайта составляет всего 83 страницы. Лучше ориентироваться именно на число в среднем т.к. низкий и высокий краулинговый бюджет это просто крайности.

Получается, что Если при правильно настроенной карте сайта sitemap.xml для первоочередного и повторного сканирования роботам поисковых систем должны предлагаться не более 83 страниц в сутки.

К этим страницам относятся все новые материалы, опубликованные на сайте, все изменения страниц по контенту, вроде новых комментариев или дополнения статей содержимым. Комментарии кстати учитываются именно встроенные в сам сайт, а не сторонние сервисы вроде формы комментариев от вконтакте.

Как увеличить краулинговый бюджет сайта

Ну во-первых как было сказано выше, у Вас должна быть хорошо настроена карта сайта sitemap.xml и файл robots.txt, ведь именно на них первым делом обращают свое внимание поисковые роботы, при посещения сайта. Именно из их содержимого они узнают что не надо индексировать и на что нужно обратить внимание и обойти в первую очередь.

Если спустя определенное время, после приведения в порядок этих файлов Вас все еще не устраивает результат по цифрам краулингового бюджета можете обратить внимание на такую штуку как параметр last-modified, о котором я напишу в отдельной статье.

Если говорить простыми словами, то настроив этот параметр у себя на сайта, При посещении страницы сайта поисковым роботом ему будет отдаваться код ответа сервера 304 — это означает что страницы не изменилась с момента последнего посещения и не надо ее повторно индексировать.

При это не растрачивается зазря единица краулингового бюджета и робот идет дальше по страницам в поисках новых или обновленных страниц. Это очень удобно использовать в крупных проектах.

В самом начале статьи, я говорил, что размер краулингового бюджета у всех сайтов разных. Связано это с тем, что каждый проект публикует разное количество материала на сайт ежедневно и краулинговый бюджет старается примерно построиться под эту цифру с небольшим запасом. К тому же и обновляется материал у кого-то по несколько раз на день, у кого-то раз в 3 месяца.

Создаваемые самим движком сайта, всевозможными фильтрами и прочими скриптами множество бесполезных страниц, которые еще и в карту сайта попадают, могут наоборот несколько подорвать краулинговый бюджет проекта и тогда заместо полезных страниц сайта в индекс будет попадать много ненужного мусора.

Поисковые роботы с легкостью могут оценивать качество таких страниц и на основе этого снижать лимит сканирования страниц для этого проекта — ибо не заслужили.